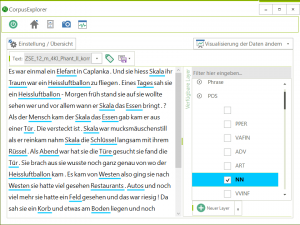

Annotierte Daten im CorpusExplorer (JOR)

Übersicht

Die computergestützte Sozio- und Diskurslinguistik versteht sich als empirische Disziplin, die ihre Hypothesen zur sozialen, kommunikativen Verfasstheit unserer Gesellschaft auf der Grundlage kontrollierter Datensammlungen (vor Textkorpora) formuliert. Gegenstand unserer Arbeit ist damit sowohl die Entwicklung von Paradigmen und Algorithmen der Korpusakquise (Korpusdesign) als auch die Aufbereitung und (je nach Datenherkunft) freie Verfügbarmachung von Korpora.

In unserem Team existieren mittlerweile zahlreiche Forschungs- und Lehrkorpora. Der Schwerpunkt unserer Arbeit und damit auch unserer Textsammlungen liegt jedoch vor allem auf Textsammlungen zur politischen Kommunikation, zur Fachkommunikation (insb. des Rechts, aber auch anderer Fachdisziplinen) sowie zur computergestützten Kommunikation (Social Media).

Nachfolgend dokumentieren wir die wichtigsten Textsammlungen unserer Arbeit, die teilweise kostenlos (nicht-kommerziell) verwendet werden können. Wenn Sie Interesse haben, im Rahmen einer Kooperation auf unsere Daten zuzugreifen, melden Sie sich gerne bei einem Mitglied unseres Teams.

Verschiedene Forschungskorpora (unter CC-Lizenz)

Folgende Korpora können kostenlos für wissenschaftliche Zwecke (nicht-kommerzielle Nutzung) heruntergeladen und genutzt werden:

kleineanfragen.de

Die Seite www.kleineanfragen.de sammelt kleine (und auch große) Anfragen der Landesparlamente und des Bundestages und versucht diese möglichst einfach auffind-, durchsuch- und verlinkbar zu machen. Die Daten auf der Webseite sind tagesaktuell – das hier verfügbare Korpus basiert auf dem Stand: 2018-05-07. Der Rohtext wurde bereinigt und mittels TreeTagger annotiert (Token, Satz, POS, Lemma). Für ein tagesaktuelles Korpus nutzen Sie bitte die Import-Funktion des CorpusExplorers. Dieses Korpus wird in regelmäßigen Abständen (ca. alle 6 Monate) aktualisiert. Der Datensatz steht unter der Open Database License (ODbL) 1.0 frei zur Verfügung.

3,3 GB – 85’021 Dokumente

17,88 Mio. Sätze – 238,59 Mio. Token

Layer: Wort, POS, Lemma

[Download über Korpus-Repository]

One Million Posts Corpus

Das „One Million Posts Corpus“ umfasst Zeitungsartikel der österreichischen Zeitung „der Standard“ – inkl. der Online-Kommentare der LeserInnen. Das Korpus wurde im Original teilweise manuell annotiert – so finden sich z. B. zu einigen Leserkommentaren Einschätzungen zu Positiv/Negativ-Wertung oder welcher Art/Domäne ein Kommentar zuzuordnen ist. Für diese Version wurde das Korpus entsprechend korpuslinguistisch aufbereitet. Link zur Original-Ressource. Das Korpus wurde unter der Lizenz: CreativeCommons BY-NC-SA 3.0 veröffentlicht.

1,0 GB – 973 Tsd. Dokumente

3,94 Mio. Sätze – 41,71 Mio. Token

Layer: Wort, Lemma, POS

[Download über Korpus-Repository]

Deutscher Bundestag Drucksachen

Unter https://www.bundestag.de/service/opendata stellt der Deutsche Bundestag alle Drucksachen (z. B. Anträge, Gesetzesvorlagen, etc.) OpenAccess in einem sehr rudimentären XML-Format bereit. Die vorhandenen Metadaten wurde extrahiert. Der Rohtext bereinigt und mittels TreeTagger annotiert (Token, Phrasen, Satz, POS, Lemma).

12,85 GB – 131833 Dokumente

44,7 Mio. Sätze – 715,15 Mio. Token

Layer: Wort, POS, Lemma, Phrase

[Download über Korpus-Repository]

Deutscher Bundestag Plenarprotokolle

Unter https://www.bundestag.de/service/opendata stellt der Deutsche Bundestag alle Plenarprotokolle OpenAccess in einem sehr rudimentären XML-Format bereit. Die vorhandenen Metadaten wurde extrahiert. Der Rohtext bereinigt und mittels TreeTagger annotiert (Token, Phrasen, Satz, POS, Lemma). In der aktuellen Version wird noch die gesamte Plenarsitzung als ein Dokument hinterlegt. Eine Aufteilung in einzelne Redebeiträge, wie im EUROPARL-Korpus, ist geplant.

5,26GB – 4106 Dokumente

18,8 Mio. Sätze – 298,60 Mio. Token

Layer: Wort, POS, Lemma, Phrase

[Download über Korpus-Repository]

W2C – Web to Corpus

Die hier zur Verfügung gestellten Korpusdaten umfassen alle deutschen Texte aus dem: Majliš, Martin, 2011, W2C – Web to Corpus – Corpora, LINDAT/CLARIN digital library at the Institute of Formal and Applied Linguistics (ÚFAL), Faculty of Mathematics and Physics, Charles University, http://hdl.handle.net/11858/00-097C-0000-0022-6133-9. Die Texte wurden tokenisiert und annotiert.

1,0 GB – 1,9 Mio. Dokumente

9,18 Mio. Sätze – 116,99 Mio. Token

Layer: Wort, Lemma, POS

[Download über Korpus-Repository]

Wikipedia !NEU!

Das Wikipedia-Korpus enthält alle Seiten der deutschsprachigen Wikipedia (Stand Juni 2019). Seiten mit Weiterleitungen oder Seiten, die von der Qualitätskontrolle geflaggt wurden, wurden entfernt. Der Rohtext wurde bereinigt (Tabellen entfernt, Referenzen entfernt, usw.), tokenisiert und mittels TreeTagger annotiert.

11,7 GB 1,27 Mio. Dokumente

64,44 Mio. Sätze – 750,04 Mio. Token

Layer: Wort, Lemma und POS

[Download über Korpus-Repository]

CEHugeWebCorpus !NEU!

Dieses Korpus wurde ursprünglich zum Testen der Performance (Serverinfrastruktur CorpusExplorer – siehe: diskursmonitor.de) erstellt. Es umfasst den gefilterten Datenbestand (ursprünglich 5.5 TB) von CommonCrawl (Stand März 2018). Zunächst wurden die URLs anhand ihrer Top-Level-Domain (de, at, ch) gefiltert. Dann wurden die Texte mittels NTextCat klassifiziert und nur eindeutig deutsche Texte wurden ins Korpus übernommen. Die Texte wurden dann mittels TreeTagger annotiert.

ca. 46 GB – 2,58 Mio. Dokumente – 232,87 Mio. Sätze – 3,021 Mrd. Token

Layer: Wort, Lemma, POS

Das Korpus steht aufgrund der Größe (komprimiert ca. 50 GB) und des Urheberrechts nur für wissenschaftliche Zwecke (auf Anfrage) zur Verfügung.

Fachtextkorpora

Referenzkorpus des deutschsprachigen Rechts (JuReko)

Gegenstand dieses Projektes ist die interdisziplinäre Konzeption, Aufbereitung und erste analytische Erschließung eines juristischen Referenzkorpus (JuReko) als quantitativ-empirischer Beitrag zur juristischen Methodik sowie zur Rechts-, Computer- und Korpuslinguistik. Das von Prof. Dr. Friedemann Vogel und Dr. Dr. Hanjo Hamann geleitete Projekt wird für fünf Jahre (2014-2019) durch die Akademie der Wissenschaften Baden-Württemberg finanziert. Mitkonzipiert und computerlinguistisch aufbereitet wird das Korpus von Isabelle Gauer.

Das Korpus wurde mit der Hilfe von xsl-Transformationen und Java-Programmen erstellt und mit PoS-Tags angereichert (TreeTagger). Alle Texte liegen TEI P5 konform vor, wobei Metadaten (zum Beispiel Titel, Autor, Gericht, Datum) ebenfalls in einer relationalen Datenbank erfasst und manuell nachkorrigiert wurden. JuReko 2.0 enthält 6.300 Gesetzestexte (~2,3 Mio. Wörter), 370.000 deutsche Gerichtsentscheidungen (~800 Mio. Wörter), 20.000 englische Entscheidungen (~90 Mio. Wörter) und 43.000 Artikel aus 21 juristischen Fachzeitschriften (~150 Mio. Wörter) ab ca. 1981 bis 2015. Damit stellt JuReko die erste repräsentative Datenbasis für quantitativ informierte rechtslinguistische Analysen dar.

Nähere Informationen auf www.jureko.de.

Fachsprachkorpus Medizin

Das Fachkorpus zur Medizin umfasst derzeit nur die englischsprachige Zeitschrift „The Lancet“ und wird in Zukunft ausgebaut. Das Korpus umfasst 183.120 Texte (346 Mio. Token) aus einem Zeitraum von 1940-2014.

Zugriff nur zu Forschungszwecken auf Anfrage.

Fachsprachkorpus Germanistische Linguistik

Das Fachtextkorpus zur Germanistischen Linguistik umfasst 7.900 Texte (26,8 Mio. Token; 1971-2014) aus den Fachzeitschriften: Zeitschrift für Germanistische Linguistik (ZGL), Linguistik Online (LO), Zeitschrift für Literaturwissenschaft und Linguistik (LiLi), Online publizierte Arbeiten zur Linguistik (OPAL), Zeitschrift für Dialektologie und Linguistik (ZDL), Deutsche Sprache (DS).

Zugriff nur zu Forschungszwecken auf Anfrage.

Fachsprachkorpus Theoretische und praktische Theologie

Das Fachtextkorpus zur theoretischen und praktischen Theologie umfasst aktuell 6.544 Texte (32,3 Mio. Token, 1950-2011) aus den Fachzeitschriften: Theologische Rundschau (ThR), Geist und Leben (GuL), Zeitschrift für Theologie und Kirche (ZThK), Theol.-Praktische Quartalschrift (ThPQ). Das theologische Fachsprachenkorpus wird ergänzend mit einem Korpus aus Texten des theologischen Vermittlungsdiskurses, bestehend aus insg. 18.049 (31,4 Mio. Token) deutschsprachigen Predigten (rh/ev) aus einem Zeitraum von 1990 bis 2015. Quellen: http://www.predigten.de/, https://predigten.evangelisch.de, http://www.sermon-online.de/, http://www.erf.de/.

Zugriff nur zu Forschungszwecken auf Anfrage.

Fachsprachkorpus Homöopathie

Das Fachtextkorpus zur Homöopathie besteht aus der „Allgemeinen Homöopathischen Zeitung“ (AHZ) und umfasst 2.734 Texte (6,8 Mio. Token) aus einem Zeitraum von 1949 bis 2014.

Zugriff nur zu Forschungszwecken auf Anfrage.

Weitere Korpora im Team CoSoDi

Folgende größere ausgewählte Textsammlungen sind im Rahmen von einzelnen Studien, Qualifikationsarbeiten entstanden und liegen (bislang mit nur eingeschränkter Nutzungslizenz) in unterschiedlicher Qualität der Aufbereitung vor. Bei Interesse melden Sie sich im Sekretariat bei Eva Kampschulte.

Presse-Textkorpora zur Analyse von Nationenimages

Medientextkorpora aus deutschsprachigen überregionalen Zeitungen und Zeitschriften zu den öffentlichen Images von China (1996-2000; 238.595 Texte, 155 Mio. Token), Türkei (1999-2008; 57 MB; 56 Mio. Token) und Ungarn (1999-2009; 15021 Texte; 12,05 Mio. Token).

Zugriff nur zu Forschungszwecken auf Anfrage.

Wikipedia – Turn-sequenziertes Teilkorpus

Korpus mit derzeit 35.376 Diskussionsseiten, 216.865 Interaktionssträngen und 1,03 Mio. Beiträgen (Turns); insg. 70 Mio. Token. Es handelt sich nicht um Artikel-Texte, sondern um einen Ausschnitt annotations- und metadatentechnisch aufbereiteter Interaktionen (getippte Gespräche) von über 30.000 Wikipedia-AkteurInnen für sozio- und medienlinguistische Untersuchungsfragen.

Zugriff nur zu Forschungszwecken auf Anfrage.